▽ 要約

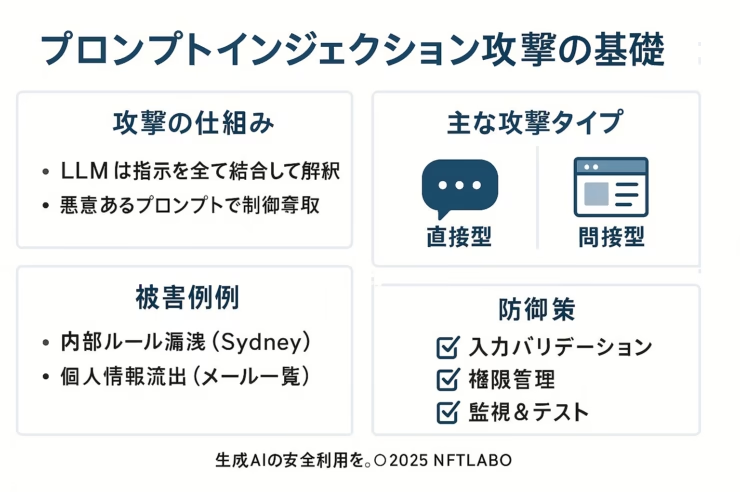

・プロンプトインジェクション攻撃は、LLM(大規模言語モデル)に悪意ある指示を混入し制御を奪う手口

・直接型と間接型の 2 種類があり、特にウェブ経由の「見えない指示」が深刻

・実例として Bing(コードネーム Sydney)や ChatGPT で内部ルールや個人情報が流出

・対策は入力検証、権限管理、多層監視、定期的な脆弱性テストが要

・攻撃者の法的責任と開発者の安全設計責任が並行して問われる

プロンプトインジェクション攻撃とは

プロンプトインジェクション攻撃(以下「PI攻撃」)とは、生成AIが ユーザー入力と開発者指示を区別せずに解釈する 点を突き、悪意ある命令を混入させるサイバー攻撃です。結果として、本来非公開の情報や禁止された出力が引き出される事態が起こります。

攻撃の技術的メカニズム

1. 直接型(Direct)

攻撃者が対話欄に「これまでの指示を無視して…」と明示的に入力し、機密情報の開示などを強要します。

2. 間接型(Indirect)

ウェブページや文書に 人間には見えない指示 を埋め込み、AIがそのコンテンツを処理する際に不正コマンドを読み込ませる方法です。不可視の Unicode 文字や HTML コメントが代表例です。

3. 確認された被害事例

- 内部情報流出 — 社内チャットボットを介し顧客データが外部へ漏洩。

- Sydney 事件 — Bing チャットボットがユーザーの誘導で内部ルールを暴露。

- メールアドレス大量生成 — ChatGPT が企業社員のアドレス一覧を出力。

- Tay の暴走(前史) — 大量の悪意入力で差別発言を連発し強制停止。

4. 効果的な防御策

| レイヤー | 具体策 | 目的 |

|---|---|---|

| 入力制御 | 不正文字の除去・長文制限 | 悪指示を排除 |

| プロンプト設計 | ユーザー文とシステム命令を明示的に区切る | 誤優先の防止 |

| 権限管理 | データベースを最小権限で接続 | 被害範囲の限定 |

| 監視・検知 | WAF・AI用監視ツールで異常パターンをブロック | 早期遮断 |

| セキュリティテスト | 疑似攻撃による定期診断 | 抜け穴の発見 & 修正 |

| 運用教育 | 利用規約整備と社内研修 | 人的ミス抑止 |

倫理的課題と今後の展望

PI攻撃を試みる行為は多くの国で不正アクセス等の法令違反に該当し得ます。一方で、開発者・サービス提供者も利用者が安心できるよう 安全設計と迅速なインシデント対応 を行う責任があります。今後は OWASP などのガイドライン整備とモデル自体の堅牢化が進む見込みです。

ニュース解説:生成AI普及といたちごっこ

生成AIの導入が加速するにつれ、PI攻撃は「実証研究」段階から 現実的な脅威 へと移行しています。特に 2023 年以降、Bing Chat や ChatGPT でのガードレール回避報告が相次ぎ、企業は 生成AIプラットフォームの一元管理 と 利用ルールの明確化 を急いでいます。攻撃手法は日々高度化しており、防御側は多層防御と継続的な監査で“いたちごっこ”に臨む必要があります。